Qwen udostępnia otwarto nowe, wszechstronne i praktyczne modele z serii Qwen2.5-Coder (0.5B/1.5B/3B/7B/14B/32B)

W świecie rozwoju oprogramowania rośnie zapotrzebowanie na coraz bardziej inteligentne, wszechstronne i wyspecjalizowane modele językowe do kodowania. Choć istniejące modele osiągnęły istotne postępy w automatyzacji generowania kodu, jego uzupełnianiu i analizowaniu, to nadal napotykają na szereg wyzwań. Kluczowe problemy obejmują brak efektywności w obsłudze różnorodnych zadań programistycznych, brak wiedzy specjalistycznej w niektórych dziedzinach oraz trudności w zastosowaniu modeli w rzeczywistych scenariuszach kodowania. Mimo rosnącej popularności dużych modeli językowych (LLM), modele specyficzne dla kodu często miały trudności z konkurowaniem ze swoimi zamkniętymi odpowiednikami, szczególnie pod względem wszechstronności i praktyczności. Potrzeba stworzenia modelu, który nie tylko dobrze radzi sobie na standardowych benchmarkach, ale także potrafi dostosować się do różnych środowisk, nigdy nie była większa.

Qwen2.5-Coder: Nowa Era Otwartych Modeli Językowych do Kodowania

Firma Qwen udostępniła otwarty kod źródłowy serii „Potężnych”, „Zróżnicowanych” i „Praktycznych” modeli Qwen2.5-Coder, które mają na celu ciągłe wspieranie rozwoju otwartych modeli językowych do kodowania (CodeLLM). Seria Qwen2.5-Coder opiera się na architekturze Qwen2.5, wykorzystując jej zaawansowaną konstrukcję oraz rozbudowany tokenizator, aby zwiększyć efektywność i dokładność zadań programistycznych. Dzięki udostępnieniu tych modeli, Qwen otworzyła drzwi do ich szerokiego wykorzystania przez programistów, badaczy oraz specjalistów z branży. Rodzina tych modeli obejmuje różne rozmiary, od 0.5B do 32B parametrów, co zapewnia elastyczność w realizacji różnorodnych potrzeb programistycznych. Wprowadzenie Qwen2.5-Coder-32B-Instruct to moment przełomowy, gdyż jest to najpotężniejszy i najbardziej praktyczny model z serii Qwen, podkreślający zaangażowanie firmy w promowanie innowacji i rozwój otwartych modeli kodowania.

Szczegóły Techniczne

Modele Qwen2.5-Coder zostały poddane rozbudowanemu pretrenowaniu na ogromnym zbiorze danych obejmującym ponad 5,5 biliona tokenów. Zbiór ten zawiera publiczne repozytoria kodu oraz dane pochodzące z dużych zbiorów web-crawlingowych zawierających teksty związane z kodowaniem. Architektura modelu jest wspólna dla różnych rozmiarów modeli – od 1.5B do 7B parametrów – z 28 warstwami, które różnią się pod względem ukrytych rozmiarów i liczby głów uwagi. Dodatkowo, Qwen2.5-Coder został dostrojony przy użyciu syntetycznych zbiorów danych generowanych przez swojego poprzednika, CodeQwen1.5. W procesie tym zaimplementowano także egzaminator (executor), który sprawdza, czy kod jest wykonywalny, zmniejszając tym samym ryzyko występowania halucynacji.

Przełomowa Wydajność

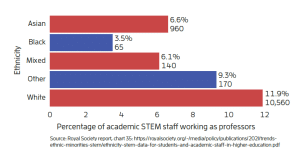

Jednym z głównych powodów, dla których Qwen2.5-Coder wyróżnia się na tle innych modeli, jest jego doskonała wydajność na wielu benchmarkach ewaluacyjnych. Modele z tej serii regularnie osiągają najlepsze wyniki (SOTA – State of the Art) na ponad 10 różnych benchmarkach, w tym HumanEval oraz BigCodeBench, przewyższając nawet większe modele. Na przykład, model Qwen2.5-Coder-7B-Base uzyskał wyższą dokładność na benchmarkach HumanEval i MBPP w porównaniu z modelami takimi jak StarCoder2 czy DeepSeek-Coder o podobnych lub większych rozmiarach. Seria Qwen2.5-Coder wyróżnia się także wszechstronnością w obsłudze wielu języków programowania, wykazując zrównoważone umiejętności w ośmiu językach, takich jak Python, Java czy TypeScript. Co więcej, zdolność Qwen2.5 do pracy z długim kontekstem sprawia, że model ten doskonale nadaje się do obsługi kodu na poziomie całych repozytoriów, umożliwiając pracę z wejściami o długości do 128k tokenów.

Skalowalność i Dostępność

Dostępność modeli w różnych rozmiarach (od 0.5B do 32B parametrów), jak również w wersjach skwantowanych, takich jak GPTQ, AWQ czy GGUF, sprawia, że Qwen2.5-Coder jest idealnym rozwiązaniem dla szerokiej gamy wymagań obliczeniowych. Skalowalność ta ma kluczowe znaczenie dla programistów i badaczy, którzy nie mają dostępu do zaawansowanych zasobów obliczeniowych, ale nadal potrzebują korzystać z potężnych narzędzi programistycznych. Wszechstronność Qwen2.5-Coder w obsłudze różnych formatów sprawia, że model ten jest bardziej dostępny do praktycznego zastosowania, co pozwala na jego szerokie przyjęcie w różnorodnych aplikacjach. Taka adaptacyjność czyni rodzinę Qwen2.5-Coder istotnym narzędziem wspierającym rozwój otwartych asystentów do kodowania.

Podsumowanie

Otwarte udostępnienie serii Qwen2.5-Coder to ważny krok naprzód w rozwoju modeli językowych do kodowania. Dzięki udostępnieniu modeli, które są potężne, zróżnicowane i praktyczne, firma Qwen rozwiązała kluczowe ograniczenia istniejących modeli specyficznych dla kodowania. Połączenie wydajności na najwyższym poziomie, skalowalności i elastyczności sprawia, że rodzina Qwen2.5-Coder to cenny zasób dla globalnej społeczności programistów. Niezależnie od tego, czy potrzebujesz mocy modelu o wielkości 0.5B, czy też preferujesz potężną wersję 32B, seria Qwen2.5-Coder jest stworzona, aby sprostać zróżnicowanym potrzebom użytkowników. Jest to doskonały moment, aby odkryć możliwości, jakie oferuje najlepszy model do kodowania od Qwen, czyli Qwen2.5-Coder-32B-Instruct, a także jego wszechstronnej rodziny mniejszych modeli. Witajmy nową erę otwartych modeli językowych do kodowania, które nadal przesuwają granice innowacji i dostępności.