Osiąganie Przyczynowego Rozplątywania z Czysto Obserwacyjnych Danych bez Interwencji

Rozplątywanie przyczynowości to kluczowy obszar w uczeniu maszynowym, który koncentruje się na izolowaniu ukrytych czynników przyczynowych z złożonych zbiorów danych, zwłaszcza w sytuacjach, gdzie bezpośrednia interwencja jest niemożliwa. Umiejętność wyciągania wniosków na temat struktur przyczynowych bez interwencji jest szczególnie cenna w takich dziedzinach jak wizja komputerowa, nauki społeczne czy nauki przyrodnicze. Pozwala to badaczom przewidywać, jak dane będą się zachowywać w różnych hipotetycznych scenariuszach. Rozwój w dziedzinie rozplątywania przyczynowości zwiększa interpretowalność oraz możliwość generalizowania modeli uczenia maszynowego, co jest kluczowe dla aplikacji wymagających solidnych prognoz.

Wyzwania w rozplątywaniu przyczynowości

Głównym wyzwaniem w rozplątywaniu przyczynowości jest identyfikacja ukrytych czynników przyczynowych bez polegania na danych interwencyjnych, czyli takich, gdzie każdy czynnik jest manipulowany niezależnie w celu obserwacji jego efektów. Ta ograniczona możliwość interwencji może być szczególnie problematyczna w sytuacjach, gdzie interwencje są niepraktyczne z powodu barier etycznych, kosztów lub trudności logistycznych. W rezultacie pojawia się pytanie: ile można nauczyć się o strukturach przyczynowych jedynie na podstawie danych obserwacyjnych, gdzie nie mamy bezpośredniej kontroli nad zmiennymi ukrytymi? Tradycyjne metody wnioskowania przyczynowego często zawodzą w takich sytuacjach, gdyż wymagają specyficznych założeń lub ograniczeń, które nie zawsze są spełnione.

Ograniczenia obecnych metod

Istniejące metody rozplątywania przyczynowości zazwyczaj opierają się na danych interwencyjnych, zakładając, że badacze mogą manipulować każdą zmienną niezależnie, aby ujawnić związek przyczynowy. Metody te opierają się również na restrykcyjnych założeniach, takich jak liniowe mieszanie lub struktury parametryczne, co ogranicza ich zastosowanie do zbiorów danych, które nie mają z góry określonych ograniczeń. Niektóre techniki próbują obejść te ograniczenia, wykorzystując dane wieloźródłowe lub wprowadzając dodatkowe ograniczenia strukturalne na zmienne ukryte. Jednak takie podejścia są nadal ograniczone w sytuacjach, gdzie dostępne są jedynie dane obserwacyjne, ponieważ nie generalizują dobrze do przypadków bez danych interwencyjnych.

Nowa metoda opracowana przez naukowców z MIT i Harvardu

Naukowcy z Broad Institute of MIT oraz Harvardu zaproponowali nowatorskie podejście do rozplątywania przyczynowości z wykorzystaniem wyłącznie danych obserwacyjnych, bez zakładania dostępu do danych interwencyjnych czy ścisłych ograniczeń strukturalnych. Ich metoda korzysta z nieliniowych modeli, które łączą szum Gaussa z nieznaną liniową funkcją mieszania, aby zidentyfikować czynniki przyczynowe. Innowacyjność tego podejścia polega na wykorzystaniu asymetrii w rozkładach wspólnych obserwowanych danych, aby wydobyć istotne struktury przyczynowe. Skupiając się na naturalnych asymetriach danych, metoda ta pozwala na wykrywanie związków przyczynowych do poziomu transformacji warstwowej, co stanowi znaczący krok naprzód w uczeniu reprezentacji przyczynowych bez interwencji.

Wykorzystanie programowania kwadratowego i dopasowywania składowych

Zaproponowana metodologia łączy dopasowywanie wyników z programowaniem kwadratowym, aby efektywnie wnioskować o strukturach przyczynowych. Wykorzystując estymowane funkcje wyników z danych obserwacyjnych, metoda izoluje czynniki przyczynowe poprzez iteracyjną optymalizację nad programem kwadratowym. Elastyczność tej metody pozwala na integrację różnych narzędzi do estymacji wyników, co czyni ją adaptowalną do różnych zbiorów danych obserwacyjnych. Badacze wprowadzają estymacje wyników do Algorytmów 1 i 2, aby uchwycić i udoskonalić warstwy przyczynowe. Ramy te pozwalają modelowi działać przy użyciu dowolnej techniki estymacji wyników, co zapewnia wszechstronne i skalowalne rozwiązanie problemów związanych z rozplątywaniem przyczynowości.

Wyniki badań i ocena skuteczności

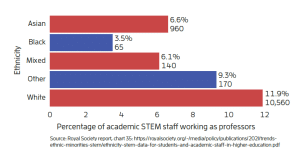

Kwantytatywna ocena metody wykazała obiecujące wyniki, potwierdzając jej praktyczną skuteczność i niezawodność. Na przykład, badacze zastosowali algorytm na czterowęzłowym grafie przyczynowym w dwóch konfiguracjach — grafie liniowym i strukturze Y. Wygenerowano 2000 próbek obserwacyjnych, a wyniki obliczono na podstawie funkcji łączących z rzeczywistymi danymi. W grafie liniowym algorytm osiągnął perfekcyjne oddzielenie wszystkich zmiennych, podczas gdy w strukturze Y dokładnie rozplątał zmienne E1 i E2, choć pewne mieszanie wystąpiło w przypadku zmiennych E3 i E4. Wartości średniego absolutnego współczynnika korelacji (MAC) między prawdziwymi a estymowanymi zmiennymi szumowymi podkreśliły skuteczność modelu w dokładnym reprezentowaniu struktur przyczynowych. Algorytm utrzymał wysoką dokładność nawet przy testach z zaszumionymi estymacjami wyników, co potwierdza jego odporność na warunki rzeczywistych danych.

Znaczenie badań dla przyszłości

Badania te stanowią istotny postęp w dziedzinie rozplątywania przyczynowości, umożliwiając identyfikację czynników przyczynowych bez potrzeby korzystania z danych interwencyjnych. Nowe podejście rozwiązuje problem osiągnięcia identyfikowalności w danych obserwacyjnych, oferując elastyczną i wydajną metodę wnioskowania przyczynowego. Otwiera to nowe możliwości w dziedzinie odkrywania przyczynowości w różnych obszarach, umożliwiając bardziej precyzyjne i wnikliwe interpretacje w sytuacjach, gdzie bezpośrednie interwencje są trudne lub niemożliwe. Dzięki rozwojowi uczenia reprezentacji przyczynowych, badania te torują drogę do szerokiego zastosowania uczenia maszynowego w dziedzinach, które wymagają solidnej i interpretowalnej analizy danych.