Od skali do gęstości: Nowe podejście oparte na AI do oceny dużych modeli językowych

Modele językowe nowej generacji – przyszłość sztucznej inteligencji

Rozwój dużych modeli językowych (LLM, ang. Large Language Models) staje się jednym z najbardziej dynamicznych i przełomowych obszarów w dziedzinie sztucznej inteligencji. Technologie te, jak GPT-3, PaLM czy Llama-3.1, osiągnęły imponujące wyniki w rozmaitych zastosowaniach, dzięki miliardom parametrów, które pozwalają im na coraz bardziej złożone operacje. Jednak ich rosnące wymagania co do mocy obliczeniowej stanowią istotne wyzwanie, szczególnie w przypadku implementacji na urządzeniach o ograniczonych zasobach, takich jak smartfony czy urządzenia IoT. Dlatego właśnie pojawia się potrzeba optymalizacji i zrównoważonego rozwoju tych modeli.

Wyzwania związane ze skalowaniem LLM

Skalowanie modeli językowych jest procesem, który pozwala zwiększać ich możliwości poprzez dodawanie większej liczby parametrów i trenowanie ich na jeszcze większych zbiorach danych. Jednakże taki wzrost prowadzi do gwałtownego wzrostu kosztów oraz zużycia energii. W przypadkach, w których modele muszą działać na platformach o niskiej mocy obliczeniowej, złożoność ich trenowania i obsługi zapytań staje się poważnym ograniczeniem. Choć skalowanie przyczyniło się do popularyzacji tych technologii, w dłuższej perspektywie okazało się ono mało zrównoważone.

Z drugiej strony, aby umożliwić zastosowanie LLM na urządzeniach o ograniczonej wydajności, konieczne jest ich uproszczenie, ale w sposób, który nie wpłynie znacząco na ich zdolności wnioskowania i produkowania odpowiedzi.

Optymalizacja poprzez nowe metody

Obecnie kluczowe metody optymalizacji obejmują skalowanie, przycinki (pruning), destylację (distillation) oraz kwantyzację (quantization). Każda z tych technik ma swoje zalety i ograniczenia. Skalowanie zwiększa możliwości modelu, ale jednocześnie wymaga większych zasobów. Przycinki redukują rozmiar modelu, usuwając mniej istotne elementy, co jednak może negatywnie wpłynąć na wydajność. Destylacja polega na trenowaniu mniejszych modeli na podstawie większych, ale obniża gęstość informacji. Z kolei kwantyzacja zmniejsza precyzję obliczeniową, co może skutkować pogorszeniem wyników.

Ze względu na te ograniczenia, badacze poszukują bardziej zrównoważonych metod, które łączą efektywność z wysoką wydajnością. Jednym z ciekawszych podejść jest skupienie się na koncepcji „gęstości zdolności” (ang. capability density) jako nowego wskaźnika optymalizacji.

Gęstość zdolności – nowy sposób oceny modeli

Zespół badaczy z Uniwersytetu Tsinghua oraz ModelBest Inc. zaproponował metrykę „gęstości zdolności” do oceny jakości modeli językowych w kontekście ich efektywności względem rozmiaru. Gęstość zdolności definiowana jest jako stosunek efektywnej liczby parametrów do rzeczywistej liczby parametrów modelu. Efektywna liczba parametrów to taka, która jest wymagana, aby osiągnąć wydajność równą modelowi referencyjnemu. Obliczenia te przeprowadza się w dwóch etapach: dopasowanie krzywej strat względem liczby parametrów, a następnie prognozowanie wyników na zadaniach testowych za pomocą funkcji sigmoidalnej.

Im wyższa gęstość, tym lepsza wydajność na jednostkę parametru, co czyni model bardziej efektywnym, szczególnie w kontekście implementacji na urządzeniach o ograniczonych zasobach.

Wyniki badań i znaczenie dla przyszłości

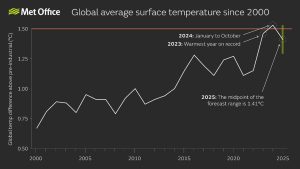

Badania przeprowadzono na podstawie analizy 29 otwartych modeli językowych, oceniając ich działanie na popularnych zestawach danych, takich jak MMLU, BBH, MATH, HumanEval i MBPP, w różnych konfiguracjach – od zero-shot po 5-shot. Modele te różniły się wielkością, długością tokenów oraz skalą danych. Wśród analizowanych rozwiązań znalazły się m.in. Llama, Falcon, MPT, Phi, Mistral i MiniCPM.

Wyniki pokazały, że z czasem gęstość modeli znacząco wzrosła. Przykładem może być MiniCPM-3-4B, który osiągnął wyższą gęstość w porównaniu do starszych modeli. Co więcej, analiza regresji liniowej wykazała, że gęstość zdolności LLM podwaja się średnio co 95 dni. Taki dynamiczny rozwój wskazuje, że mniejsze, bardziej zoptymalizowane modele w niedalekiej przyszłości będą mogły konkurować z większymi modelami zarówno pod względem kosztów, jak i możliwości.

Nowa era modeli językowych

Metodyka badawcza i wyniki analiz sugerują, że nadchodzące modele językowe będą nie tylko coraz wydajniejsze, ale również bardziej przystępne do implementacji w rozmaitych środowiskach. Wprowadzenie koncepcji gęstości zdolności stanowi istotny krok w kierunku zrównoważonego rozwoju tej technologii.

Przyszłość dużych modeli językowych leży w efektywności i optymalizacji, co pozwoli na ich szerokie zastosowanie – nie tylko w dużych centrach danych, ale także na urządzeniach osobistych i przemysłowych o niskiej mocy obliczeniowej. To może być przełom, który otworzy nowe możliwości w dziedzinie sztucznej inteligencji.