Naukowcy z Georgia Tech i IBM przedstawiają KnOTS: bezgradientowe ramy AI do łączenia modeli LoRA

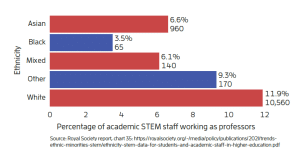

Model merging, czyli łączenie modeli, to innowacyjna technika, która umożliwia tworzenie wszechstronnych modeli wielozadaniowych, poprzez łączenie wag modeli specyficznych dla określonych zadań. Dzięki tej metodzie możliwe jest gromadzenie umiejętności, naprawianie słabości modeli oraz wspólne doskonalenie już istniejących rozwiązań. Choć ta technika odniosła duże sukcesy w przypadku pełnych modeli dopasowanych (FFT), pojawiają się liczne wyzwania, gdy próbujemy zastosować ją do metod finetuningu oszczędzających parametry (PEFT), takich jak Adaptacja Niskiego Rzędu (LoRA). Analiza przeprowadzona za pomocą wyrównania z jądrem centroidów (CKA) pokazuje, że w przeciwieństwie do modeli FFT, które charakteryzują się wysokim wyrównaniem aktualizacji zadań, modele LoRA wykazują znacznie niższe wyrównanie. Wynika to z faktu, że ich aktualizacje przetwarzają dane wejściowe poprzez niezgodne podprzestrzenie.

Rozwiązania dla wyzwań w łączeniu modeli

W odpowiedzi na wyzwania związane z łączeniem modeli, powstały różne podejścia bazujące na koncepcji łączności trybów, gdzie wartości parametrów niezależnie trenowanych sieci neuronowych mogą być interpolowane bez zwiększenia błędu testowego. Jednym z takich podejść jest Task Arithmetic (TA), które wprowadziło pojęcie „wektorów zadań” poprzez odejmowanie parametrów modelu przed treningiem od tych po treningu. Metoda TIES natomiast zaproponowała rozwiązanie problemu interferencji parametrów poprzez selektywne uśrednianie wag o dominujących znakach. DARE z kolei zbadał możliwości zastosowania rzadkich wektorów zadań poprzez losowe usuwanie wag. Niestety, te techniki napotykają na ograniczenia w kontekście modeli LoRA, ze względu na zwiększoną splątanie wag między modelami.

Nowe podejście: KnOTS

Zespół badaczy z Georgia Tech, IBM Research oraz MIT zaproponował innowacyjne rozwiązanie o nazwie KnOTS (Knowledge Orientation Through SVD), które przekształca aktualizacje zadań różnych modeli LoRA w wspólną przestrzeń za pomocą dekompozycji wartości osobliwych (SVD). Metoda ta jest kompatybilna z istniejącymi technikami łączenia modeli i oferuje uniwersalność w zastosowaniach. KnOTS działa poprzez łączenie aktualizacji zadań dla każdej warstwy modelu i ich dekompozycję przy użyciu SVD. Co więcej, badacze wprowadzili nowy wzorzec oceny „joint-evaluation”, który umożliwia testowanie zdolności złączonych modeli do jednoczesnej obsługi danych wejściowych z różnych zbiorów, bez konieczności korzystania z kontekstu specyficznego dla danego zbioru danych. Dzięki temu możliwe jest realistyczne ocenienie zdolności modelu do generalizacji w szerokim zakresie zadań.

Etapy działania KnOTS

KnOTS wprowadza złożoną architekturę, która działa w kilku etapach, aby efektywnie wyrównywać i łączyć modele LoRA. Metoda ta współpracuje z kilkoma istniejącymi podejściami nie bazującymi na gradientach, takimi jak RegMean, Task-Arithmetic (TA), TIES i DARE. RegMean wykorzystuje liniową regresję w zamkniętej formie, aby wyrównywać wagi modeli, podczas gdy TA wykonuje bezpośrednią sumację parametrów z użyciem współczynników skalowania. TIES udoskonala to podejście, wprowadzając przycinanie parametrów oparte na ich wielkości oraz rozwiązywanie konfliktów znakowych. DARE z kolei wprowadza element probabilistyczny, losowo przycinając parametry według rozkładu Bernoulliego. Badacze wykorzystali również metodę Ensemble, która przetwarza dane wejściowe przez wszystkie modele, wybierając przewidywania na podstawie najwyższych wyników pewności.

Wyniki eksperymentalne

Badania eksperymentalne potwierdzają skuteczność KnOTS w kontekście różnych architektur modelowych i zadań. W dziedzinie analizy obrazów, podczas łączenia ośmiu modeli ViT-B/32, które zostały dostrojone na różnych zbiorach danych do klasyfikacji obrazów, KnOTS osiągnął wyniki porównywalne z istniejącymi metodami. Jeszcze bardziej imponujące wyniki uzyskano przy większych modelach ViT-L/14, gdzie KnOTS-TIES przewyższyło istniejące rozwiązania nawet o 3%. W dziedzinie analizy języka naturalnego, podczas testowania na modelach Llama3-8B dostosowanych do zadań inferencji językowej, KnOTS-TIES znacząco poprawił wyniki bazowe, osiągając do 2,9% wyższą średnią znormalizowaną dokładność. Ponadto, kombinacja KnOTS-DARE-TIES podniosła wydajność o dodatkowe 0,2%.

Podsumowanie

W artykule opisano metodę KnOTS, która wykorzystuje dekompozycję wartości osobliwych (SVD) do przekształcania aktualizacji zadań modeli LoRA w wspólną przestrzeń reprezentacji, umożliwiając zastosowanie różnych technik łączenia bez gradientów. Dodatkowo, wprowadzono nowy wzorzec oceny, który bada zdolność połączonych modeli do obsługi danych z różnych zbiorów bez specyficznego kontekstu. Wyniki licznych eksperymentów wskazują na wysoką skuteczność KnOTS, która poprawia wydajność istniejących podejść nawet o 4,3%, potwierdzając jej uniwersalność i efektywność w różnych architekturach modelowych i zadaniach. KnOTS stanowi obiecujące narzędzie do tworzenia ogólnych, wielozadaniowych modeli poprzez efektywne wyrównywanie i łączenie reprezentacji LoRA.