Microsoft wprowadza LLM2CLIP: Nową technikę AI, w której model językowy pełni rolę nauczyciela dla wizualnego kodera CLIP

W dzisiejszych czasach, CLIP (Contrastive Language–Image Pretraining) jest jednym z kluczowych modeli bazowych wykorzystywanych w multimodalnych zadaniach uczenia maszynowego. Model ten łączy sygnały wizualne i tekstowe, tworząc wspólną przestrzeń cech, co umożliwia efektywne uczenie kontrastowe na dużą skalę z wykorzystaniem par obraz-tekst. CLIP może być używany do wielu zadań, takich jak klasyfikacja bez potrzeby trenowania (zero-shot), detekcja, segmentacja oraz wyszukiwanie obraz-tekst. Jako ekstraktor cech, CLIP dominuje w praktycznie wszystkich zadaniach związanych z reprezentacją między modalnościami, obejmujących rozumienie obrazów, filmów i generowanie tekstu na podstawie obrazu lub filmu.

Jego siła wynika przede wszystkim z umiejętności łączenia obrazów z językiem naturalnym, jak również z faktu, że jest trenowany na dużych zbiorach danych internetowych z bogatymi opisami tekstowymi. Dzięki temu potrafi efektywnie kodować wiedzę ludzką w sposób bardziej zrozumiały niż tradycyjne enkodery wizji. Wraz z szybkim rozwojem dużych modeli językowych (LLM), granice rozumienia i generowania tekstu są nieustannie przesuwane. Modele LLM, dzięki swoim zaawansowanym umiejętnościom przetwarzania tekstu, mogą pomóc CLIP w lepszym radzeniu sobie z długimi i złożonymi opisami, co było dotychczas jego słabą stroną. LLM-y również posiadają szeroką wiedzę o ogromnych zbiorach danych tekstowych, co może uczynić proces treningowy bardziej efektywnym.

Rozwój CLIP i wyzwania związane z LLM

Obecny rozwój technologii poszerzył możliwości CLIP, umożliwiając mu obsługę innych modalności, co znacząco zwiększyło jego wpływ na dziedzinę sztucznej inteligencji. Nowe modele, takie jak Llama3, zostały wykorzystane do wydłużenia opisów generowanych przez CLIP oraz poprawy jego wydajności poprzez wykorzystanie otwartej wiedzy z LLM. Jednakże, połączenie LLM z CLIP nie jest proste ze względu na ograniczenia tekstowego enkodera CLIP. W licznych eksperymentach wykazano, że bezpośrednia integracja LLM z CLIP prowadzi do obniżenia wydajności. Stąd przed badaczami stoi wyzwanie, by pokonać te problemy i w pełni wykorzystać potencjał wynikający z włączenia LLM do CLIP.

Podejście LLM2CLIP

Naukowcy z Uniwersytetu Tongji oraz Microsoft Corporation przeprowadzili szczegółowe badania i zaproponowali nowe podejście o nazwie LLM2CLIP, które ma na celu poprawę wizualnej reprezentacji poprzez integrację dużych modeli językowych. Metoda ta polega na zastąpieniu oryginalnego tekstowego enkodera CLIP modelem językowym LLM oraz na wzmocnieniu wizualnego enkodera CLIP przy pomocy szerokiej wiedzy z LLM. Pomimo, że początkowe próby spotkały się z wyzwaniami, badacze zaproponowali efektywny kosztowo sposób tuningu, który pozwolił na przezwyciężenie tych trudności.

W ramach tego podejścia, zamiast oryginalnego tekstowego enkodera CLIP, zastosowano model LLM, co początkowo napotykało problemy związane z rozróżnianiem opisów obrazów. W odpowiedzi na to wprowadzono technikę fine-tuningu kontrastowego dla opisów, co znacznie poprawiło zdolność modelu LLM do rozróżniania podpisów. Dzięki temu, uzyskano znaczną poprawę wydajności, przewyższającą dotychczasowe modele.

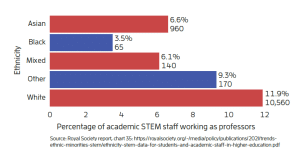

Wyniki badań i testy

Eksperymenty skupiały się głównie na tuningu modeli pod kątem lepszego dopasowania obraz-tekst przy użyciu zbiorów danych takich jak CC-3M. Do testów użyto trzech różnych rozmiarów zestawów danych: małego (CC-3M), średniego (CC-3M i CC-12M) oraz dużego (CC-3M, CC-12M, YFCC-15M i Recaption-1B). Trening z rozszerzonymi opisami poprawił wydajność, podczas gdy użycie nieprzetrenowanego modelu językowego dla CLIP pogorszyło wyniki. Modele trenowane z LLM2CLIP przewyższyły standardowy CLIP oraz EVA w zadaniach takich jak wyszukiwanie obraz-tekst oraz tekst-obraz, co podkreśla przewagę integracji dużych modeli językowych w pracy z obrazami i tekstem.

Przewaga nad istniejącymi modelami

Metoda LLM2CLIP bezpośrednio zwiększyła wydajność poprzedniego modelu SOTA EVA02 o 16,5% w zadaniach związanych z wyszukiwaniem zarówno długich, jak i krótkich opisów. W wyniku tego, CLIP, który wcześniej był trenowany jedynie na danych w języku angielskim, został przekształcony w model wielojęzyczny o najlepszych wynikach. Po zintegrowaniu treningu multimodalnego z modelami, jak Llava 1.5, wydajność CLIP wzrosła we wszystkich benchmarkach, co pokazało znaczące ogólne ulepszenia.

Wnioski i przyszłe perspektywy

Proponowana metoda pozwala dużym modelom językowym na wspomaganie treningu CLIP. Dzięki dostosowywaniu parametrów takich jak rozkład danych, długość czy kategorie, LLM może zostać zmodyfikowany w taki sposób, aby naprawić ograniczenia CLIP. W ten sposób modele LLM mogą pełnić rolę bardziej kompleksowych nauczycieli w wielu zadaniach. W prezentowanym badaniu, gradienty LLM zostały zamrożone podczas tuningu, co umożliwiło utrzymanie dużej partii danych do treningu CLIP. W przyszłości, LLM2CLIP może być trenowany od podstaw na zbiorach danych takich jak Laion-2B i Recaption-1B, aby osiągnąć jeszcze lepsze wyniki i wydajność. Praca ta może służyć jako punkt odniesienia dla przyszłych badań nad treningiem CLIP i jego szerokim zastosowaniem!