„Profesor z Stanford oskarżony o korzystanie z AI przy tworzeniu opinii eksperckiej na temat deepfake’ów”

Ekspert z Uniwersytetu Stanford oskarżony o użycie fałszywych informacji generowanych przez AI

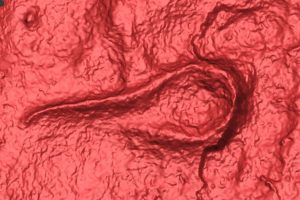

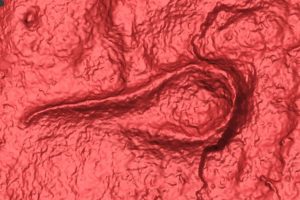

W niecodziennej i ironicznej sytuacji, profesor z Uniwersytetu Stanford został oskarżony o rozprzestrzenianie fałszywych informacji generowanych przez sztuczną inteligencję. Co ciekawe, miało to miejsce w trakcie jego wystąpienia jako biegłego eksperta w sprawie związanej z prawem mającym na celu przeciwdziałanie dezinformacji generowanej przez AI w kontekście wyborów.

Kontekst prawny i sporna opinia eksperta

Jeff Hancock, założyciel i dyrektor Laboratorium Mediów Społecznościowych na Uniwersytecie Stanford, przedstawił swoją opinię ekspercką na początku listopada w sprawie Kohls v. Ellison. Sprawa ta dotyczy prawa stanu Minnesota, które kryminalizuje użycie deepfake’ów w celu wpływania na wyniki wyborów. Nowe przepisy zostały zakwestionowane przez YouTubera Christophera Kohlsa (znanego jako Mr. Reagan) oraz senator stanu Minnesota Mary Franson. Oskarżyciele twierdzą, że prawo narusza Pierwszą Poprawkę do Konstytucji Stanów Zjednoczonych, gwarantującą wolność słowa.

W swojej opinii Hancock odwołał się do rzekomego badania zatytułowanego „Wpływ deepfake’ów na postawy i zachowania polityczne”, opublikowanego w czasopiśmie Journal of Information Technology & Politics. Jak jednak zauważyli prawnicy strony skarżącej, badanie to… nie istnieje. Co więcej, sugerują, że powołanie się na nie może być wynikiem „halucynacji” generowanej przez sztuczną inteligencję, najprawdopodobniej przy użyciu modelu językowego takiego jak ChatGPT.

Zarzuty wobec opinii eksperckiej

W pozwie podkreślono, że brak rzeczywistego źródła cytowanego przez Hancocka podważa wiarygodność całego dokumentu. Prawnicy zwrócili uwagę, że w opinii eksperta nie tylko brakuje metodologii, ale również logicznej analizy, co rodzi poważne wątpliwości co do jej wartości jako dowodu w sprawie. „Nie jest jasne, w jaki sposób ten błąd trafił do oświadczenia profesora Hancocka, ale podważa to jego całą wiarygodność” – napisali prawnicy w swoim wniosku o wykluczenie opinii eksperta.

Sprawa zyskała rozgłos po publikacji w lokalnych mediach, jednak sam Hancock jak dotąd nie odniósł się do zarzutów.

Regulacje dotyczące deepfake’ów w Minnesocie i innych stanach

Minnesota to jeden z dwudziestu stanów w USA, które wprowadziły przepisy regulujące wykorzystanie deepfake’ów w kampaniach politycznych. Nowe prawo zabrania świadomego lub lekkomyślnego rozpowszechniania deepfake’ów w okresie do 90 dni przed wyborami, jeśli materiał przedstawia osobę bez jej zgody i jest zamierzony jako forma wpływu na wynik głosowania.

Jednak nowe regulacje wzbudzają kontrowersje, szczególnie wśród konserwatystów i zwolenników nieograniczonej wolności słowa. Oskarżyciele w sprawie Kohls v. Ellison utrzymują, że prawo jest zbyt restrykcyjne i może ograniczać możliwość wyrażania opinii w sposób satyryczny lub krytyczny.

Podobne przypadki i szeroki kontekst

To nie pierwszy raz, kiedy przepisy dotyczące deepfake’ów trafiają do sądu. W Kalifornii podobna ustawa została tymczasowo zablokowana przez federalnego sędziego po tym, jak Christopher Kohls zakwestionował jej zgodność z konstytucją. Decyzja sądu federalnego o wydaniu wstępnego nakazu wstrzymania egzekwowania prawa odbiła się szerokim echem i wywołała dyskusje na temat granic regulacji związanych z technologiami AI.

Znaczenie sprawy dla przyszłości regulacji AI

Sprawa Hancocka pokazuje, jak trudne może być rozstrzyganie kwestii związanych z technologiami generatywnymi, takimi jak sztuczna inteligencja. Paradoksalnie, osoba mająca zapobiegać dezinformacji generowanej przez AI sama znalazła się w centrum kontrowersji dotyczącej wykorzystania tej technologii. To wydarzenie podkreśla potrzebę ostrożnego podejścia do wprowadzania nowych regulacji, jak również odpowiedzialność ekspertów w zakresie korzystania z wiarygodnych źródeł.

Przypadek ten może również wpłynąć na postrzeganie roli sztucznej inteligencji w procesach sądowych i politycznych na całym świecie. Wraz z rosnącym zastosowaniem AI w różnych dziedzinach życia, konieczne będzie wypracowanie bardziej transparentnych i skutecznych metod weryfikacji informacji, aby uniknąć podobnych wpadek w przyszłości.