ADOPT: Uniwersalna adaptacyjna metoda gradientu dla pewnej zbieżności bez potrzeby dostrajania hiperparametrów

Adam to jeden z najczęściej używanych algorytmów optymalizacji adaptacyjnej w głębokim uczeniu, jednak często napotyka trudności z konwergencją, chyba że parametry takie jak β2 zostaną odpowiednio dostosowane do specyficznego problemu. Próby naprawy tego problemu, jak AMSGrad, opierają się na założeniu o jednolicie ograniczonym szumie gradientu, co nie zawsze znajduje zastosowanie, szczególnie w przypadkach, gdzie występuje szum Gaussowski, jak ma to miejsce w autoenkoderach wariacyjnych czy modelach dyfuzyjnych. Inne rozwiązania, takie jak AdaShift, zapewniają konwergencję w specyficznych warunkach, ale nie są skuteczne w bardziej ogólnych przypadkach. Ostatnie badania wskazują, że Adam może osiągnąć konwergencję poprzez precyzyjne dostosowanie parametru β2 w zależności od zadania, jednak takie podejście jest skomplikowane i wymaga dalszych badań w celu opracowania uniwersalnych rozwiązań.

Wprowadzenie ADOPT

Naukowcy z Uniwersytetu Tokijskiego przedstawili nowy algorytm o nazwie ADOPT (Adaptive Gradient Method), który oferuje optymalną konwergencję z szybkością O(1/√T), bez potrzeby specyficznego doboru wartości β2 oraz bez konieczności przyjmowania założenia o ograniczonym szumie gradientu. ADOPT radzi sobie z problemem braku konwergencji Adama poprzez wykluczenie bieżącego gradientu z obliczeń drugiego momentu oraz zmianę kolejności aktualizacji momentu i normalizacji. Eksperymenty przeprowadzone na różnych zadaniach, takich jak klasyfikacja obrazów, modelowanie generatywne, przetwarzanie języka naturalnego oraz uczenie ze wzmocnieniem, wykazały, że ADOPT przewyższa Adama i jego warianty pod względem wydajności. Algorytm ten również osiąga stabilną konwergencję w przypadkach, gdzie Adam i AMSGrad mają trudności.

Problemy z optymalizacją stochastyczną

W badaniu skupiono się na minimalizacji funkcji celu zależnej od wektora parametrów, wykorzystując metody optymalizacji stochastycznej pierwszego rzędu. Zamiast używać dokładnego gradientu, posłużono się jego oszacowaniem, znanym jako gradient stochastyczny. Ponieważ funkcja może być niekonweksyjna, celem jest znalezienie punktu stacjonarnego, gdzie gradient jest równy zero. Standardowe analizy konwergencji w tym obszarze zakładają kilka kluczowych aspektów: funkcja ma dolne ograniczenie, gradient stochastyczny zapewnia nieobciążone oszacowanie gradientu, funkcja zmienia się płynnie, a wariancja gradientu stochastycznego jest ograniczona. W przypadku metod adaptacyjnych, takich jak Adam, często wprowadza się dodatkowe założenie dotyczące wariancji gradientu, aby uprościć dowody konwergencji. Badacze postanowili zbadać, jak metody adaptacyjne mogą osiągnąć konwergencję bez korzystania z bardziej restrykcyjnych założeń na temat szumu gradientu.

Ograniczenia Adama i rozwój AMSGrad

Dotychczasowe badania sugerują, że chociaż podstawowy stochastyczny spadek gradientu często osiąga konwergencję w przypadkach niekonweksyjnych, metody adaptacyjne, takie jak Adam, są szeroko stosowane w głębokim uczeniu ze względu na swoją elastyczność. Jednak Adam nie zawsze dobrze sobie radzi w przypadkach konweksyjnych. Aby temu zaradzić, opracowano modyfikację o nazwie AMSGrad, która wprowadza niesłabnące skalowanie współczynnika uczenia przez aktualizację oszacowania drugiego momentu przy użyciu funkcji maksimum. Mimo to, konwergencja AMSGrad opiera się na silniejszym założeniu o jednolicie ograniczonym szumie gradientu, co nie zawsze jest prawdziwe, na przykład w niektórych modelach generatywnych. Dlatego naukowcy zaproponowali nowe podejście do aktualizacji gradientu adaptacyjnego, które ma na celu zapewnienie niezawodnej konwergencji bez konieczności opierania się na surowych założeniach dotyczących szumu gradientu, skutecznie rozwiązując ograniczenia Adama.

Testy i wyniki ADOPT

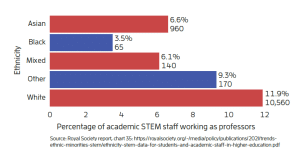

Algorytm ADOPT został przetestowany na różnych zadaniach, aby zweryfikować jego wydajność i odporność w porównaniu do Adama i AMSGrad. Już w przypadku prostego problemu testowego ADOPT zdołał osiągnąć konwergencję, gdzie Adam zawiódł, szczególnie w warunkach wysokiego szumu gradientu. Testy przeprowadzone z użyciem sieci MLP na zbiorze danych MNIST oraz ResNet na CIFAR-10 pokazały, że ADOPT osiąga szybszą i bardziej stabilną konwergencję. Algorytm ten przewyższył Adama również w bardziej zaawansowanych zastosowaniach, takich jak klasyfikacja obrazów na bazie Swin Transformer na zbiorze ImageNet, modelowanie generatywne NVAE oraz pretrening GPT-2 w warunkach szumu gradientu. Ponadto, ADOPT zapewnił lepsze wyniki w dostrajaniu modelu językowego LLaMA-7B na benchmarku MMLU.

Przyszłość adaptacyjnych metod optymalizacji

Badanie zwraca uwagę na teoretyczne ograniczenia adaptacyjnych metod gradientu, takich jak Adam, które wymagają precyzyjnych ustawień hiperparametrów w celu uzyskania konwergencji. Aby rozwiązać te problemy, autorzy proponują ADOPT, optymalizator, który osiąga optymalne tempo konwergencji w różnych zadaniach bez potrzeby dostosowywania parametrów do specyficznych problemów. ADOPT przezwycięża ograniczenia Adama, zmieniając kolejność aktualizacji momentu oraz wykluczając bieżący gradient z obliczeń drugiego momentu, co zapewnia stabilność w zadaniach takich jak klasyfikacja obrazów, przetwarzanie języka naturalnego oraz modelowanie generatywne. Badanie stanowi most między teorią a praktyką w adaptacyjnej optymalizacji, chociaż przyszłe badania mogą skupić się na bardziej zrelaksowanych założeniach, aby jeszcze bardziej uogólnić skuteczność ADOPT.

—

Badanie podkreśla potrzebę dalszych badań nad adaptacyjnymi metodami optymalizacji, które pozwolą na lepsze dostosowanie algorytmów do rzeczywistych problemów bez konieczności złożonych ustawień parametrów.