SVDQuant: Nowatorskie 4-bitowe Uczenie Kwantyzacji dla Modeli Dyfuzji

Wraz z szybkim rozwojem modeli dyfuzji pojawiły się wyzwania związane z wysokim zużyciem pamięci i opóźnieniami, co utrudnia ich wdrożenie, szczególnie w środowiskach o ograniczonych zasobach. Modele te zyskały uznanie dzięki zdolności do generowania obrazów o wysokiej wierności, ale jednocześnie wymagają ogromnych zasobów pamięci i mocy obliczeniowej, co ogranicza ich dostępność na urządzeniach konsumenckich oraz w aplikacjach, gdzie kluczowa jest niska latencja. Aby duże modele dyfuzji mogły być efektywnie trenowane i wdrażane w czasie rzeczywistym na różnych platformach, konieczne jest rozwiązanie tych problemów.

Problemy z pamięcią i prędkością w modelach dyfuzji

Obecne techniki rozwiązujące problemy z pamięcią i prędkością w modelach dyfuzji obejmują kwantyzację po-treningową oraz kwantyzację świadomą treningu, w szczególności z wykorzystaniem metod kwantyzacji wyłącznie wag, takich jak NormalFloat4 (NF4). Chociaż te metody sprawdzają się w modelach językowych, nie są wystarczająco skuteczne w przypadku modeli dyfuzji, które wymagają większej mocy obliczeniowej. W odróżnieniu od modeli językowych, modele dyfuzji potrzebują jednoczesnej kwantyzacji wag i aktywacji przy niskiej liczbie bitów, aby uniknąć degradacji wydajności. Obecne metody kwantyzacji napotykają trudności związane z obecnością wartości odstających zarówno w wagach, jak i aktywacjach przy 4-bitowej precyzji, co prowadzi do pogorszenia jakości wizualnej oraz nieefektywności obliczeniowych, co wskazuje na potrzebę bardziej zaawansowanego rozwiązania.

SVDQuant jako nowoczesne podejście do kwantyzacji

Naukowcy z MIT, NVIDIA, CMU, Princeton, UC Berkeley, SJTU oraz Pika Labs opracowali nową metodę kwantyzacji o nazwie SVDQuant. Podejście to wprowadza gałąź niskiego rzędu, która absorbuje wartości odstające, umożliwiając skuteczną kwantyzację modeli dyfuzji przy użyciu 4-bitowej precyzji. Dzięki innowacyjnemu wykorzystaniu rozkładu SVD (rozłożenie według wartości osobliwych) do radzenia sobie z wartościami odstającymi, SVDQuant przenosi te wartości z aktywacji do wag, a następnie absorbuje je w gałęzi niskiego rzędu. Pozostała część wag jest kwantyzowana przy 4-bitowej precyzji bez utraty wydajności, co eliminuje konieczność ponownej kwantyzacji i optymalizuje cały proces bez dodatkowych obciążeń.

W celu dalszej optymalizacji, naukowcy opracowali silnik inferencyjny o nazwie Nunchaku, który łączy obliczeniowe jądra niskiego rzędu i niskiej precyzji z optymalizacją dostępu do pamięci, co pozwala na znaczną redukcję opóźnień.

Zastosowanie SVDQuant i jego korzyści

SVDQuant działa poprzez wygładzanie i przenoszenie wartości odstających z aktywacji do wag, a następnie stosowanie rozkładu SVD do wag, dzieląc je na komponent niskiego rzędu i resztę. Komponent niskiego rzędu pochłania wartości odstające przy 16-bitowej precyzji, podczas gdy reszta jest kwantyzowana przy 4-bitowej precyzji. Silnik inferencyjny Nunchaku optymalizuje ten proces, umożliwiając jednoczesne działanie gałęzi niskiego rzędu i niskiej precyzji, co zmniejsza dostęp do pamięci i przyspiesza procesy obliczeniowe.

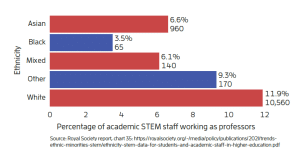

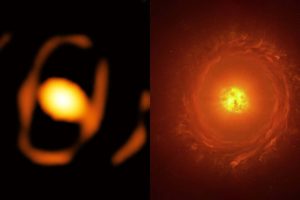

Testy przeprowadzone na modelach takich jak FLUX.1 i SDXL, przy użyciu zbiorów danych MJHQ i sDCI, wykazały znaczne oszczędności pamięci (nawet 3,5 razy) oraz redukcję opóźnień do 10,1 razy na urządzeniach typu laptop. Na przykład, zastosowanie SVDQuant w modelu FLUX.1, który ma 12 miliardów parametrów, zredukowało jego rozmiar z 22,7 GB do 6,5 GB, co eliminuje konieczność przenoszenia obliczeń na CPU w środowiskach o ograniczonej pamięci.

Wyższość SVDQuant nad konkurencyjnymi rozwiązaniami

SVDQuant przewyższa istniejące metody kwantyzacji zarówno pod względem efektywności, jak i jakości wizualnej. W przypadku kwantyzacji 4-bitowej, SVDQuant wykazuje stałą i wysoką zgodność percepcyjną, przy jednoczesnym zachowaniu wysokiej jakości numerycznej, istotnej dla zadań generowania obrazów. Wyniki testów na wielu architekturach modeli, takich jak FLUX.1-dev, pokazują, że konfiguracja SVDQuant była dobrze dostrojona, uzyskując wyniki zbliżone do 16-bitowego punktu odniesienia, jednocześnie oszczędzając 3,5 razy na rozmiarze modelu i przyspieszając działanie na urządzeniach GPU o około 10,1 razy, bez konieczności przenoszenia obliczeń na CPU.

Takie rozwiązanie umożliwia generowanie obrazów w czasie rzeczywistym na urządzeniach o ograniczonej pamięci, co otwiera drogę do praktycznego wdrażania dużych modeli dyfuzji w rzeczywistych aplikacjach interaktywnych na sprzęcie konsumenckim.

Podsumowanie

SVDQuant to nowoczesne podejście do kwantyzacji, które skutecznie rozwiązuje problem wartości odstających w modelach dyfuzji, umożliwiając jednoczesne zachowanie wysokiej jakości obrazów oraz znaczne oszczędności pamięci i redukcję opóźnień. Optymalizacja procesu kwantyzacji oraz eliminacja zbędnych operacji dzięki silnikowi Nunchaku stanowi fundament efektywnego wdrażania dużych modeli dyfuzji, co otwiera nowe możliwości ich zastosowania w rzeczywistych aplikacjach interaktywnych, nawet na urządzeniach konsumenckich.